Forse nelle loro mitologie le Intelligenze Artificiali del futuro narreranno le gesta di AlphaGo, il guerriero delle pietre nere e bianche che sconfisse orde di umani (anche alle intelligenze digitali avanzate piacerà esagerare…).

Il Go è un gioco di strategia di origine cinese, il più antico tra quelli ancora giocati. Nella Cina imperiale era considerato più un’arte che un passatempo ed era compreso nelle quattro arti essenziali insieme a pittura, calligrafia e musica.

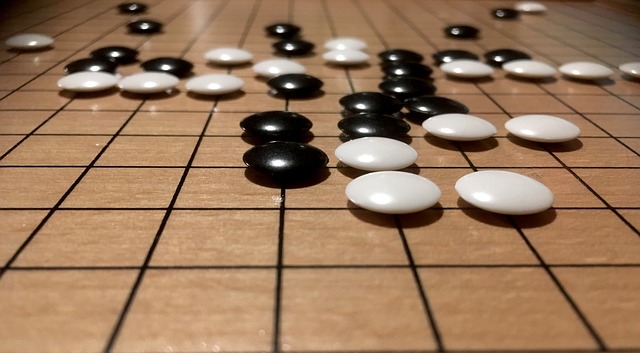

Il campo di gioco è una scacchiera (“goban”) formata da 19 linee orizzontali e 19 verticali per 361 intersezioni. I giocatori hanno un certo numero di pedine (“pietre”), bianche o nere, da posizionare a turno sulle intersezioni vuote. Scopo del gioco è quello di circondare con le proprie pietre più spazio (intersezioni vuote) del proprio avversario.

A differenza degli scacchi, che sono un gioco “distruttivo”, in cui cioè la complessità diminuisce a ogni mossa, per il Go vale il contrario: questo fa sì che il numero di possibili posizioni è nell’ordine di 10¹⁷⁰, molto, molto più alto del numero di atomi in tutto l’universo, 10⁸⁰. Il Go è più intuitivo degli scacchi: questi possono rappresentarsi come un enorme albero pieno di biforcazioni, il Go come un paesaggio astratto in cui è però possibile riconoscere schemi e strutture.

Navigare in questo oceano di possibilità rende il gioco un’esperienza senza fine, una tela in perenne tessitura in cui si intrecciano intuito e logica, poesia e matematica. Come in quest’ultima, semplici regole danno origine a “bellissime complessità”. Non per nulla Go è amato da molti matematici che considerano la posizione finale di una partita come una congettura matematica e il gioco come i passi logici necessari per dimostrare quella congettura.

Fino a pochi anni fa gli stessi matematici, esperti giocatori e programmatori erano d’accordo nel sostenere che fosse estremamente difficile scrivere un software che giocasse in maniera soddisfacente a Go: la loro previsione era che ci sarebbero voluti decenni per emulare la “bravura” dei migliori programmi di scacchi in grado oggi di battere anche campioni del mondo (senza essere DeepBlue).

Si sbagliavano.

Demis Hassabis è stato un enfant prodige dell’informatica, reclutato a soli 16 anni dall’Università di Cambridge. Nei corsi di AI che seguì i professori insistevano nel sottolineare l’impossibilità di far giocare decentemente Go a un computer. Lui la prese come una sfida.

La sua idea era semplice: invece di scrivere un programma che potesse giocare a Go, scrivere un meta-programma. Un programma che apprendesse da solo quel che era necessario, come un neonato.

Per far questo si rese conto di dover approfondire le sue conoscenze sul cervello umano e si prese un dottorato in Neuroscienze all’University College di Londra.

A questo punto — siamo nel 2010 — insieme a due soci fondò la società DeepMind.

Naturalmente cominciarono con qualcosa di semplice. Presero un vecchio gioco Atari, Breakout (sì, quello del muro di mattoncini da abbattere) e scrissero un programma che riceveva come input lo stato dei pixels dello schermo, il punteggio corrente e l’obbiettivo di massimizzarlo. Un tipico esempio di reinforcement learning (apprendimento con rinforzo), una tecnica di apprendimento automatico in cui un algoritmo impara interagendo con il suo ambiente. Il processo avviene senza l’intervento di un essere umano: il programma riceve premi svolgendo compiti correttamente e penalità in caso contrario. L’apprendimento con rinforzo è una classica tecnica che deriva dalla psicologia comportamentista: una ricompensa positiva aumenta la tendenza a fare di nuovo una certa cosa e viceversa.

Il programma iniziò a giocare con mosse casuali, poi queste diventarono sempre più efficaci. Piuttosto velocemente individuò il trucco che tutti i ragazzini degli anni ’80, dopo centinaia di partite, scoprivano: aprire un varco nel muro e far sì che la pallina vi entrasse e dall’interno demolisse il muro.

Nel 2014 i programmi “incubati” da DeepMind riuscirono a superare le abilità umane in 49 giochi Atari. Venne anche pubblicata una ricerca sulla prestigiosa rivista scientifica Nature.

La società — un ibrido tra startup e accademia — contava in quel momento 400 tra ingegneri e neuroscienziati. Google la acquistò per 500 milioni di dollari.

Comprensibilmente soddisfatto Hassabis si concentrò sulla sua sfida a Go.

Il progetto per creare un maestro digitale assunse il nome di AlphaGo.

Il programma si basa sulle reti neurali. Si è partiti da un database di 30 milioni di posizioni derivanti da partite giocate tra umani.

Una rete neurale profonda è stata addestrata con un supervised learning (apprendimento supervisionato) per calcolare, a partire da ogni posizione, quali fossero le mosse più promettenti. Questa prima fase è durata tre settimane. A questo punto il programma aveva l’abilità di un giocatore amatoriale.

Nella seconda fase (reinforcement learning) — durata un giorno — il programma ha cominciato a giocare contro sé stesso, migliorandosi. Una seconda rete neurale venne affiancata alla prima. Il suo compito era dare un valore alla situazione attuale sulla scacchiera: più alto il valore, maggiori le possibilità di vincere. Per calcolare questo valore si devono simulare le mosse successive. Si è ricorso a una “vecchia” tecnica dell’AI: un’esplorazione dell’albero delle possibilità con un algoritmo Monte Carlo tree search. La ricerca è stata resa fattibile e meno onerosa grazie ai risultati delle due reti neurali.

Ancora una fase di training di una settimana e AlphaGo era pronto per essere messo alla prova con un maestro umano.

Nel 2015, in un test segreto, AlphaGo sconfisse 5–0 il campione europeo di origini cinesi Fan Hui. Il programma continuò a imparare.

Nel marzo 2016 è il turno del pluricampione del mondo coreano Lee Sedol, tra i più grandi maestri viventi. Stavolta la sfida fu pubblicizzata e mandata in onda in diretta streaming da Seul. Il vincitore avrebbe guadagnato un milione di dollari.

Fan Hui era diventato nel frattempo una sorta di “allenatore” di AlphaGo, scovando le debolezze nel suo gioco e contribuendo a migliorare le sue performance. Sì, sembra di rivivere l’epopea di Rocky e Apollo Creed…

Nella prima partita della sfida AlphaGo vinse. Lee Sedol affermò che non si sarebbe aspettato di perdere una partita. Ma il peggio, per lui, doveva ancora arrivare. Nella seconda partita AlphaGo effettuò una mossa del tutto inaspettata, non ortodossa, “aliena” come ha rivelato un maestro occidentale, Michael Redmond. Lo shock del mondo dei giocatori di Go è grande. Millenni di sfide tra umani non avevano prodotto una tale strategia. Fan Hui perde la seconda partita e, alla fine, perderà la sfida per 4–1.

AlphaGo rimase imperturbabile. Neanche un “bip” di soddisfazione. Ma dimostrò di possedere intuizione e creatività.

La storia non finisce qui.

AlphaGo ha ancora un retaggio umano, avendo iniziato il suo processo di apprendimento da partite giocate da esseri in carne e ossa.

Alla DeepMind vogliono andare oltre.

Viene creata una nuova versione del programma, AlphaGo Zero. Paradossalmente è più semplice della precedente, con una sola rete neurale che ingloba le due esistenti. Stavolta nessuna “contaminazione” umana: AlphaGo Zero viene istruito con le regole del Go e fatto giocare solo con sé stesso. Dopo 40 giorni e 29 milioni di partite giocate è pronto per sfidare il suo predecessore.

100 volte più veloce e 10 volte più efficiente, AlphaGo Zero batte AlphaGo per 100 a 0.

Senza pregiudizi biologici e con la capacità di “guardare oltre,” AlphaGo Zero è libero di esprimere le sue potenzialità.

Come è stata vissuta questa vicenda dal mondo del Go? Come uno smacco insopportabile? Come una frustrazione insuperabile? Tutt’altro. I giocatori — primo tra tutti Fan Hui, la prima “vittima” — hanno imparato a loro volta dall’avversario digitale, migliorando il loro gioco e sfruttando nuove strategie prima “bloccate” dalla forza della tradizione.

L’eredità del progetto AlphaGo va oltre i programmi di gioco; diverse caratteristiche lo rendono un passo importante verso le AGI (Artificial General Intelligence), intelligenze digitali in grado di competere con gli esseri umani in molteplici campi e non solo in domini ristretti. Più specificatamente, comunque, il progetto ha dimostrato che in settori in cui le strategie sono importanti, come quello degli investimenti, quello politico e quello militare le AI sono quasi pronte a sfidare (o aiutare) i migliori strateghi umani.

A proposito di strategie — geopolitiche in questo caso — c’è da notare che il successo di AlphaGo ha avuto una enorme eco in Cina, patria del Go, tanto da spingere il governo cinese a varare un grande piano di investimenti per diventare entro il 2030 il principale centro di innovazione al mondo in AI.

Riferimenti

John Brockman (a cura di), Possible Minds: Twenty-Five Ways of Looking at AI, Penguin Press, 2019

Marcus Du Sautoy, The Creativity Code: How AI is learning to write, paint and think, Fourth Estate, 2019

Terrence J. Sejnowski, The Deep Learning Revolution, The MIT Press, 2018

Max Tegmark, Vita 3.0: Essere umani nell’era dell’intelligenza artificiale, Raffaello Cortina Editore, 2018

Dawn Chan, The AI That Has Nothing to Learn From Humans

Jonathan Hui, AlphaGo: How it works technically? (Una sintetica ma chiara guida tecnica al funzionamento di AlphaGo…)

Jonathan Hui, AlphaGo Zero — a game changer. (How it works?) (…e di AphaGo Zero)

David Silver, Demis Hassabis, AlphaGo Zero: Starting from scratch

David Silver et al., Mastering the game of Go without human knowledge, Nature, 2017/10/18/online, Macmillan Publishers Limited, part of Springer. (L’articolo pubblicato su Nature relative ad AlphaGo Zero)